High-dimensional asymptotics of VAEs: threshold of posterior collapse and dataset-size dependence of rate-distortion curve

J. Stat. Mech. (2025) 073402

市川くんのVariational AutoEncoderのレプリカ法による解析の論文は以下のように公開された。

Yuma Ichikawa and Koji Hukushima,

“High-dimensional asymptotics of VAEs: threshold of posterior collapse and dataset-size dependence of rate-distortion curve,”

Journal of Statistical Mechanics: Theory and Experiment(2025) Vol. 7 073402. Mech. (2025) 073402

VAEの統計力学的研究は先にダイナミクスに関する論文がAISTATに採択されていたが、この論文の方が先にできてた。今回、論文掲載はあとになったのは、機械学習系のConferenceを一周したのが原因である。その過程ではやや不毛なやり取りを続けたけど、最終的に一番有益なコメントはこの雑誌の査読レポートだったというのはこの分野の現状を表している気はする。それでも、やりとりを続けて、可読性は上がっただろうし、議論も骨太くなったこともあったので、悪いことばかりではなかった。「レプリカ解析」のwordが表題にないのは、こうした経緯によるものである。レプリカ法が問題なく認知されているのは(統計)物理学の分野だけで、物理学の外側では認知されてきているが完全に認められているわけではない。

さて、ここでは論文の周辺の解説をしたいが、まずは機械学習と物理学の関係を見渡すことから始めたい。何度かここでも記している気がするが、機械学習に関する物理学の研究は「機械学習を使う物理学の研究」と「統計物理学を使う機械学習の研究」の2つに大別できると思う。この考え方自体が古い可能性も否定できないが、「研究」とか「学」の話しようとするとこの2つになるだろう。それ以外のことは個人的には関心がない。前者は、現代的には普通に行われいて、物理学が対象に選ばれる必要は現代的には全くなく、さまざまな〇〇学へ機会学習は使われている。物質探索などスクリーニングとしての活用は、他の分野と全く同様であり、物理学の特性は訓練データの精度や質にあるとは思うし、物質科学の探索に関しては物質の多様性に比べてデータの種類が少なくて学習しきれないというのが現状かと思う。予測は当たればよいが、どのくらいで当たるかの不確実度も評価しないと、次の実験には進みにくいと思う。ただ、このあたりは探索もロボットで自動探索させる時代になるだろうし、インターフェースにLLMが挟まって、もやは人間なしで物質探索するようになるかもしれない。一方で、予測モデルをサロゲートとして活用するところは、腕の見せ所だろうとは思う。一般に、重たい第一原理モデルをサロゲートに置き換えたい課題はたくさんあるし、ある種の変分問題に機械学習サロゲートモデルをもってくるのもたくさん研究は進んでいる。もともと〇〇変分試行関数とか言っていたころは、提案する〇〇さんの気持ちが入っていて、そのお気持ちがわかった感につながる面白さがあったわけだけど、もはや人手で変分関数を作る時代ではないと言われればそれまでである。既知の試行関数を吹っ飛ばしてニューラルネットで置き換えたときに精度と引き換えに味わいが失われてしまい、「それでいいじゃないか」って感じになるなら物理学も成り下がったものだなぁと思うしかない。ただ、改めて変分アプローチを思い直すと変分原理に支えられて、行けるところまで行けばよいという思想なので、それほど魂を売っているわけでもない気がする。個人的には変分問題はそれでよいとして、サロゲートの使い方としては、いわゆる機械学習ポテンシャルみたいに完全に機械学習モデルに乗っかちゃうのではなくて、Metropolis棄却を入れて、あくまでも本物の研究にするのがよいと思っちゃうし、それに要する計算資源も問題無い時代が来るだろうと思う。

そして、前置きが長くなっちゃったけど、後者のアプローチ、すなわち機械学習の理論的な側面を明らかにする方向性に属する典型的な研究が、この研究である。情報統計力学と呼ばれる王道的な研究と言ってよいと思う。私はもともと動機づけに関してやや苦手にしていたけど、こんなに機械学習の時代が来るとやる気は俄然あがってくる。機械学習の数理的な研究は、もちろん物理学が主たる研究方法ではない。(数理)統計学の研究者が脈々と継承してきた文化がこれまでにあり、そこに物理学、特に統計力学からのアプローチするには新規性が求められる。それがHigh-dimensional asymptoticsである。統計力学では熱力学極限をとることで数理的にきれいな世界があることを知っていて、そこから有限の世界を見る思想である。機械学習における極限はいろいろありうるが、ここで考える極限は統計学が得意とする訓練データ数無限大の極限とはちょっと違って、訓練データ数の無限大極限をとるとともに、データの次元も同時に無限大極限をとり、その比αを固定する状況を考える。これで議論できるところは、データの次元とデータ数の比、すなわちdata complexityを特徴づける量を変えたときの性質である。通常?議論されるのは、データの次元が有限のまま無限のデータ数が得られる場合であり、それはα=無限大に対応するが、今回はその比を固定したことで変えることができることが重要である。

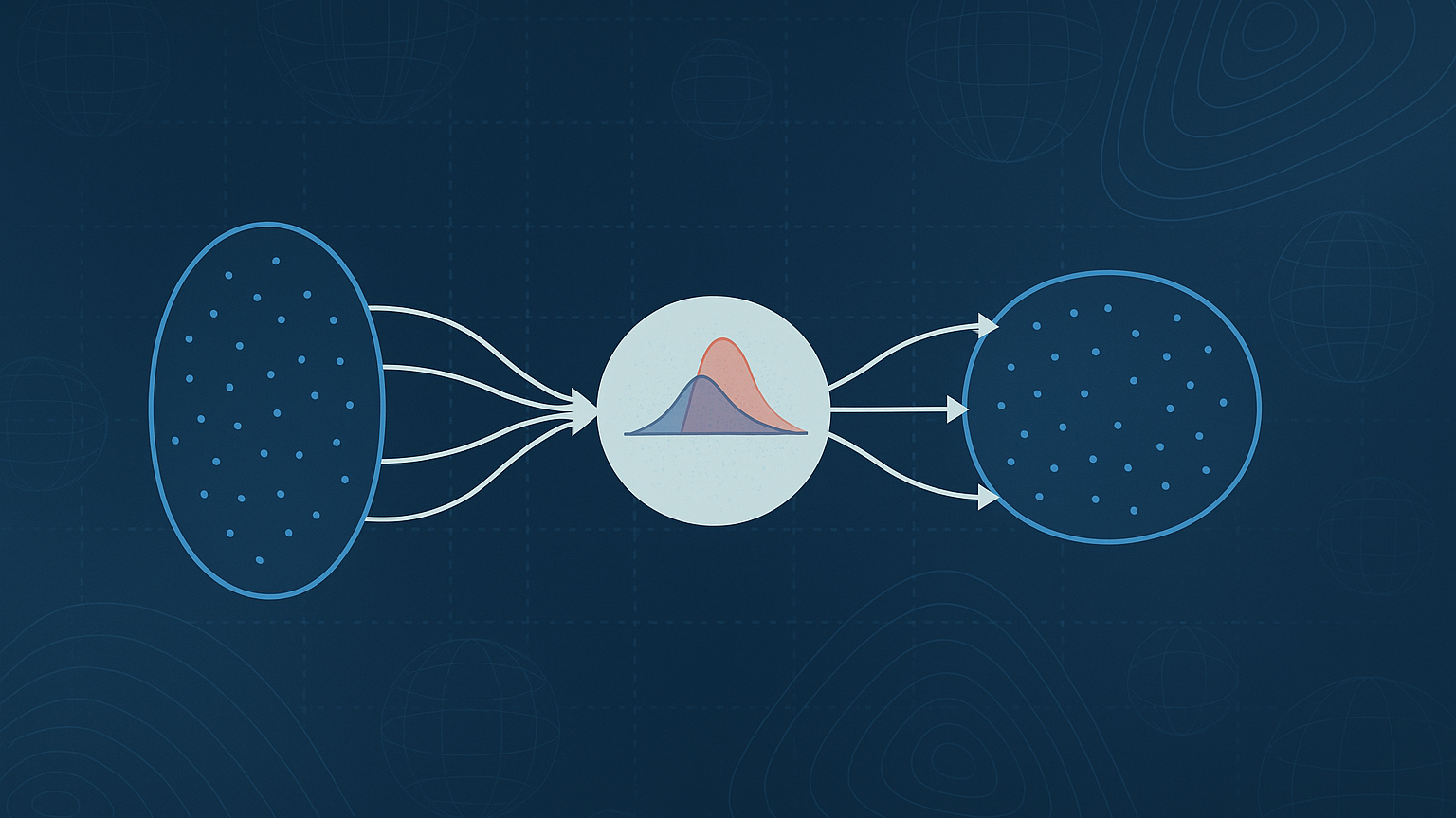

そして、対象としてはとりあげているのはVAEである。VAEは潜在変数を持つencoder-decoder型の機械学習モデルで、その典型性能をレプリカ法で評価している。ネットワークは線形に限定されたLinear VAEであるが、このモデルに関して典型的な性質の解析が完全にできることが統計力学の強みである。さらに、応用の現場でよく使われるパラメータβVAEを導入し、その影響を詳しく調べている。このパラメータは潜在変数の事前分布とencoder分布の距離に対する罰則項を調整し、大きいほど事前分布に引っ張られることになる。応用では、このパラメータを適当に調整して学習が行われるが、たびたびβVAEが大きすぎると、posterior collapseと呼ばれる現象が起き、生成モデルが事前分布に引っ張られ過ぎて表現能力が落ちてしまう。この研究では、その出現条件を物理学の「相図」として提示している。しかも、このパラメータがある定数よりも大きくなると、どんなにdata complexityを大きくして、実質的なサンプル数を無限大にしても、posterior collapseが避けられないことが示された。これは証明ではなくて、計算で示した結果である。証明が好きな人もたくさんいるとは思うけど、私は計算の方が好きなのである。とてもかっこいい研究だと思う。計算はすべて市川くんが計算したんですけどね。計算だけでなくて、VAEの研究を提案したのも、posterior collapseを知っていたのも市川くんなのである。レプリカ法のゴリゴリ計算だけど、渋いけど細かいところがいろいろ詰められている。安定性解析とか本当に普通にやるべきことがちゃんとしている研究である。

それでも「そもそもlinear じゃないか?」というのは当然のツッコミで、まあ、ある意味でちゃんと論文を読んでなくても誰でもできる質問である。気持ちもわかるし、ツッコミの意義もとてもよくわかる。今回の研究の結果にはいくつかの重要なメッセージがあるが、実データで普通の?VAEを用いて数値実験して、βVAEを大きくしたときに最適な値が存在し、さらに大きくしすぎるとposterior collapseが起こることなど、そのメッセージは定性的に成り立つことを確認している。linearモデルで得た知見がnon-linearな世界で必ずしも成り立つわけではない、非線形なめんなよって考える人もおおいと思う。だけど、逆に線形なめんなよってところも認識すべきだとは思うのだよ。minimalなモデルを考えて、ガッツリ調べるのが物理学の典型的な立場で、そこから得られる知見はしっかりあると思う。Ising模型はとても磁石のモデルとは思えないかもしれないけど、おどろくほどたくさんのことを人類に教えてくれたっていうか、人類は明らかにしてきたのである。西森さんの情報統計力学の教科書がでたころは、「実験による解くべき課題」が少なく、天才がHopfield模型を思いついて記憶という現象を切り出したように、非自明な現象がたくさん転がっていたというわけではなくて、うまく切り出たのだと思う。しかし、現代のAI・機械学習の現場は巨大な実験場になっていて、そこには不思議な現象がごろごろしている気がする。まだまだ切り込める課題はたくさんあると思っている。